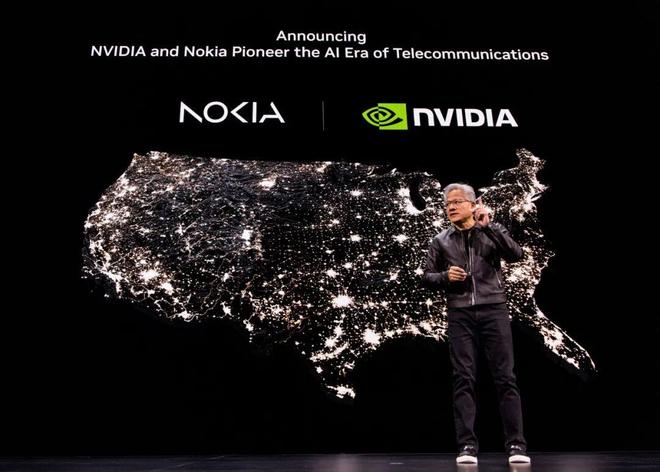

联手诺基亚入局6G,老黄要制定全球标准!GTC最新演讲揭秘:「美国科技的未来」就靠这6张王牌

每一个人都应该看一下老黄在华盛顿 GTC 大会的演讲,去看看英伟达,老黄眼中的“美国科技的未来”

在我看来,这个发布会的最大的“震撼”是英伟达要和诺基亚合作干6G,重新构筑世界的通信系统

简单来说老黄描绘了一幅以美国为中心的 AI 世纪蓝图,从6G,大规模部署 GPU 和量子技术突破,到人工智能工厂、机器人技术和自动驾驶汽车,每一项举措都在构建美国的人工智能骨干网络,整个演讲主要涉及6大核心:

1.利用物理人工智能和数字孪生技术重塑美国工业化

2.利用人工智能原生 6G 技术制定全球标准

3.借助 NVIDIA NVQLink 巩固量子领导地位

4.利用安全、可部署的人工智能基础设施设计实现政府现代化

5.构筑美国开源模型的骨干网络

6.利用统一的 DRIVE Hyperion 生态系统加速自动驾驶

以下是详细信息:

新计算范式:加速计算

在演讲的开篇,老黄指出,计算行业正面临六十年来最重要的一次模式转变。这一转变的根源在于传统计算增长规律的终结与新需求的爆发

摩尔定律的黄昏与登纳德缩放定律的终结

长期以来,计算性能的提升依赖于摩尔定律(Moore’s Law),即芯片上的晶体管数量大约每两年翻一番。然而,更关键的是登纳德缩放定律(Dennard scaling),它保证了随着晶体管变小,其功耗密度保持不变,从而使得性能提升的同时不会带来过热问题

老黄明确指出,登纳德缩放定律在近十年前就已经失效。虽然晶体管数量仍在增加,但其性能和能效的提升速度已大大减缓,受到了物理定律的限制。这意味着,仅仅依靠增加晶体管数量来提升 CPU 性能的传统路径已经走到了尽头

加速计算的必然性与 CUDA 的核心价值

Nvidia 很早就预见到了这一趋势,并开创了一种新的计算模型——加速计算(Accelerated computing)。其核心思想是将串行处理的 CPU 与大规模并行处理的 GPU 相结合,让两者各司其职,从而突破传统计算的瓶颈

然而,加速计算并非简单的硬件替换,它需要一个全新的编程模型。你不能直接将为 CPU 串行执行编写的软件放在 GPU 上运行,那样甚至会更慢。必须重新发明算法、创建新的软件库,甚至重写整个应用程序

这正是 Nvidia 耗费近三十年时间打造的核心宝藏——CUDA(Compute Unified Device Architecture,计算统一设备架构)。CUDA 不仅仅是一个 GPU,它是一个完整的编程平台,包含了一整套丰富的软件库和工具。老黄强调,人们常常关注 GPU 硬件本身,但如果没有 CUDA 这个编程模型,以及 Nvidia 对其长达十几代产品(目前已发展到 CUDA 13/14)的兼容性维护,开发者将无法有效地利用 GPU 的强大算力

CUDA X:赋能千行百业的软件宝库

Nvidia 的真正护城河是建立在 CUDA 之上的庞大软件库生态,即 CUDA X。演讲中列举了超过 350 个库中的一部分,展示了其应用的广度与深度:

cuLitho:计算光刻库,耗时七年研发,现已被台积电(TSMC)、三星(Samsung)、阿斯麦(ASML)等半导体巨头用于芯片制造的最前端环节

Monai:全球排名第一的医疗影像 AI 框架

Ariel:用于无线通信系统的库,是实现 6G 和 AI 融合的关键

cuQuantum:用于量子计算模拟的库

cuDNN:深度神经网络库,是引爆本轮 AI 革命的基础。Megatron Core 库在其之上构建,使得训练超大规模语言模型成为可能

其他还包括用于数据科学的 cuDF、用于 CAE(计算机辅助工程)的稀疏求解器、用于模拟的 Warp Python 求解器等

每一个库都代表着 Nvidia 针对一个特定领域,通过重新设计算法,将该领域带入加速计算时代。这不仅为生态伙伴创造了价值,也为 Nvidia 开拓了全新的市场。从医疗健康、制造业到自动驾驶,加速计算正在重塑每一个行业

重新定义 AI:新的工业引擎

老黄认为,公众对 AI 的认知大多停留在 ChatGPT 这样的聊天机器人上,但这远非 AI 的全貌。AI 正在从两个层面引发深刻的变革:它彻底重塑了计算技术栈,并催生了一个全新的产业

AI 的新计算栈

传统的软件开发模式是程序员手动编写代码,在 CPU 上运行,而 AI 时代的软件开发,则是通过机器学习的方式,用海量数据来“编程”或“训练”一个模型,这个模型运行在 GPU 上,这一转变导致整个计算技术栈发生了颠覆性变化。这个新的技术栈自下而上依次是:

1. 能源 :AI 计算是能源密集型的

2. GPU 基础设施 :由海量 GPU 连接构成的数据中心,其规模远超以往

3. Token(令牌)生成 :这些 GPU 超级计算机将能源转化为被称为“Token”的数字。Token 是 AI 的基本计算单元和词汇表。几乎任何有结构的信息都可以被“Token 化”,包括文本、图像、视频、3D 结构、化学物质、蛋白质、基因,甚至是机器人的动作和行为

4. AI 模型 :一旦信息被 Token 化,AI 模型就可以学习其语言和内在含义,从而实现理解、回应和生成。Transformer 只是众多模型架构中的一种,此外还有 CNN(卷积神经网络)、状态空间模型、图神经网络等,适用于不同类型的任务。

5. 应用 :构建在模型之上的具体应用。

AI 是“工作”,而非“工具”

老黄提出了一个深刻的洞见:传统软件是工具,而 AI 是工作

Excel、Word、浏览器都是工具,需要人类去使用它们。工具产业的规模是有限的,IT 工具市场大约为一万亿美元

AI 则不同,它本身可以成为劳动者,能够自主使用工具来完成任务。比如:

Perplexity AI:是一个能够使用浏览器工具来预订假期或购物的 AI

Cursor:是一个“代理式 AI“,Nvidia 的每一位软件工程师都在使用它作为编程伙伴。Cursor 使用的工具是 VS Code

自动驾驶汽车:车内有一个无形的AI 司机,它在从事驾驶工作,而汽车就是它使用的工具

由于 AI 能够直接参与到价值创造的工作环节,它所能触及的市场规模将远超传统 IT 行业。它将直接赋能价值一百万亿美元的全球经济,提高生产力,解决劳动力短缺问题

AI 工厂:一个全新的产业

除了改造现有产业,AI 还催生了一个全新的产业——生产智能(即 Token)的产业,与传统的数据中心不同,老黄将未来的计算中心称为“AI 工厂”。它的特点是:

单一目的:它的唯一产品就是 Token。它不像传统数据中心那样存储文件、运行各种应用,而是专注于 AI 计算

价值导向:工厂的目标是生产尽可能有价值(即更智能)的 Token

效率驱动:它追求以极高的速率和尽可能低的成本来生产这些 Token。

这个 AI 工厂的新产业,正是驱动对 GPU 需求呈指数级增长的根本原因

Blackwell 革命与极限协同设计

面对 AI 带来的指数级算力需求,以及摩尔定律失效的双重挑战,Nvidia 的答案是“极限协同设计”(Extreme Co-design)。Blackwell 架构是这一理念的巅峰之作

双重指数增长的压力与良性循环

AI 的算力需求面临着双重指数增长:

1. 技术的指数增长 :AI 模型的智能化过程(预训练、后训练、推理/思考)需要越来越大的计算量。特别是思考过程,即推理,远比人们想象的要复杂和耗算力

2. 市场的指数增长 :模型越智能,就越有价值,越多人和企业愿意付费使用(例如 Cursor、Midjourney 等)。使用量的增加反过来又需要更多的算力。

这两个指数增长形成了一个强大的“良性循环”:更多的算力投入 -> AI 变得更智能 -> 吸引更多用户和应用 -> 产生更多利润 -> 投入更多算力。

要维持这个循环高速运转,关键在于必须持续地、大幅度地降低 Token 的生成成本和响应时间

极限协同设计:超越芯片的系统性创新

仅仅设计更快的单颗芯片,性能提升只能是百分比级别的,无法满足指数级的需求,Nvidia 的方法是“极限协同设计”:从一张白纸开始,同时考虑和重新设计整个技术栈的每一个环节,包括新的芯片架构、新的系统设计、新的网络技术、新的软件、新的 AI 模型架构,乃至新的应用

这是一个从“scale up”(单机扩展)到“scale out”(横向扩展)再到“gigascale”(千兆级规模)的全方位设计:

Scale Up:将多个 GPU 芯片通过高速互联技术(NVLink)组合成一个机架规模的巨型 GPU

Scale Out:通过专为 AI 设计的 Spectrum-X Ethernet 网络技术,将多个机架连接成一个 AI 超级计算机集群

Gigascale:通过 Spectrum-XGS 技术,将多个数据中心连接起来

Blackwell 架构:性能与成本效益的飞跃

Grace Blackwell GB200 系统是极限协同设计的产物。其核心是 NVLink 72,一个将 72 个 Blackwell GPU 连接成一个统一计算单元的机架系统,它解决了大模型中“专家混合”(Mixture of Experts, MoE)模型的通信瓶颈。在旧系统中,一个 GPU 可能需要为 32 个专家模型服务;而在 NVLink 72 系统中,由于互联带宽极大提升,一个 GPU 只需服务 4 个专家,效率天差地别

性能飞跃:根据第三方基准测试,Grace Blackwell 每个 GPU 的性能是上一代 H200 的 10 倍

尽管 GB200 是有史以来最昂贵的计算机,但由于其极高的 Token 生成效率,它反而成为了全球生成 Token 成本最低的方案。这对于维持 AI 的良性循环至关重要

惊人的商业增长与“美国制造”的回归

Blackwell 带来了前所未有的商业增长。老黄透露,到 2026 年,公司对 Blackwell 和早期 Rubin 产品的累计业务可见性已达到五千亿美元

Blackwell 的初期产量(预计 2000 万颗 GPU)将是其前代 Hopper 整个生命周期产量(400 万颗 GPU)的五倍

更重要的是,Blackwell 将实现Made in America。从亚利桑那州的晶圆,到印第安纳州的 HBM 内存,再到德克萨斯州的系统组装,Nvidia 正在将高端制造业带回美国

Rubin 平台

演讲的高潮之一是老黄发布了下一代平台——Rubin。Vera Rubin 是第三代机架规模计算机,它实现了完全无电缆设计和 100% 液冷,集成了新的 Vera Rubin CPU、Rubin GPU、新的网络芯片 ConnectX-9 和数据处理器 BlueField-4

AI 工厂与数字孪生

随着计算单元从芯片扩展到整个数据中心,Nvidia 的设计视野也随之扩展。他们现在不仅设计 AI 超级计算机,更设计和运营整个AI 工厂,而实现这一点的关键技术是数字孪生(Digital Twin)

Omniverse DSX:AI 工厂的设计与运营蓝图

Nvidia 推出了 Omniverse DSX,一个用于构建和运营千兆瓦级AI 工厂的蓝图,这是一个革命性的理念:首次将建筑、电力、冷却系统与 AI 计算基础设施本身进行协同设计

设计阶段:

合作伙伴(如 Jacobs Engineering、西门子、施耐德电气等)在 Omniverse 的数字孪生环境中,使用各自的 OpenUSD 资产,共同规划工厂的布局、电力和散热方案

他们可以使用 CUDA 加速的工具(如 Ansys、Cadence 的软件)来模拟热流和电气性能,从而在动工前就找到最优设计。

建造阶段:

采用预制模块化的方式,在工厂内完成制造和测试,然后运到现场像乐高一样拼接起来,这大大缩短了建设周期

运营阶段:

物理工厂上线后,数字孪生成为其操作系统,工程师可以指挥在数字孪生中预先训练好的 AI 代理,实时优化能源消耗,减少对电网的压力

据估算,对于一个 1 吉瓦(gigawatt)的 AI 工厂,DSX 带来的优化每年可以增加数十亿美元的额外收入

物理 AI 的数字孪生:从工厂到机器人

数字孪生的应用不止于 AI 工厂本身,它也是实现物理 AI——即机器人技术的关键

在与富士康(Foxconn)合作的案例中,他们在德克萨斯州休斯顿建造的 Nvidia AI 基础设施制造工厂,就是“生于数字”(born digital)的。

整个工厂的布局和流程在西门子基于 Omniverse 的数字孪生解决方案中进行优化。

工厂内的机器人(如 Fanuc 的机械臂、自主移动机器人 AMRs)首先在 Isaac Sim 的模拟环境中进行训练和测试

通过 Omniverse 进行大规模传感器模拟,让机器人 AI 学会作为一个整体协同工作。部署后,基于 Metropolis 和 Cosmos 的视觉 AI 代理会从上方监控整个工厂的运作,发现异常、安全隐患甚至质量问题

这个案例生动地展示了未来制造业的图景:一个由机器人构成的工厂,在数字孪生中被精心编排,用以制造机器人化的产品

6G、量子计算与开源模型

除了在核心的 AI 计算领域持续深耕,Nvidia 也在积极布局下一代颠覆性技术,并强调开放生态的重要性

6G 通信:重塑无线网络

老黄指出,Nvidia 看到了一个机会,即利用 AI 和加速计算的平台转变为契机,重夺在 6G 时代的领导地位

Nvidia 与诺基亚(Nokia),全球第二大电信设备制造商,达成重要合作。推出了一个全新的产品线:Nvidia ARC(Aerial Radio Network Computer,空中无线电网络计算机)

ARC 是一个基于 Grace CPU、Blackwell GPU 和 ConnectX 网络的软件定义的可编程计算机,它运行名为 Ariel 的 CUDA X 库,实际上是一个运行在 CUDA 上的无线通信系统

这一合作将带来两大革命:

1. AI for RAN(AI 赋能无线接入网) :利用 AI 和强化学习,实时调整波束成形,优化信号传输,从而提高频谱效率。这不仅能传输更多数据,还能节省全球约 1.5-2% 的电力消耗

2. AI on RAN(无线接入网上的 AI) :将基站转变为边缘计算节点。就像 AWS 在互联网之上建立了云计算一样,Nvidia 和诺基亚将在无线通信网络之上建立一个庞大的“边缘工业机器人云”,将云端 AI 能力直接推向数据无法到达的边缘地带

量子计算

经过 40 年的发展,量子计算领域取得了突破,现在已经可以制造出单个稳定的、可纠错的“逻辑量子比特”

然而,量子比特极其脆弱,需要复杂的控制和纠错机制。Nvidia 认为,量子计算机(QPU)的未来在于与经典超级计算机(GPU)的紧密结合,为此,Nvidia 推出了 NVQLink,一种新的互联架构,可以直接连接量子处理器和 Nvidia GPU,NVQLink 能够以极高的速度(每秒数 TB)在 QPU 和 GPU 之间传输数据,这对于实时量子纠错至关重要

基于此,CUDA Q 平台得以扩展,支持 QPU 和 GPU 协同工作,在微秒级延迟内完成混合计算任务。

这项技术得到了业界的广泛支持,包括 17 家量子计算公司和美国能源部(DOE)下属的几乎所有主要国家实验室。Nvidia 还宣布将与 DOE 合作建造七台新的 AI 超级计算机,以推动美国在科学领域的领导地位

开源模型

Nvidia 坚信开源模型对整个生态系统至关重要。随着推理能力的增强、多模态能力的发展和蒸馏技术的成熟,开源模型对于开发者,尤其是初创企业而言,变得前所未有的强大和实用。研究人员需要开源,开发者需要开源,全世界的公司都需要开源

因此,Nvidia 投入巨大资源,成为了开源社区最大的贡献者之一,在语言、物理 AI、生物学等多个领域的排行榜上拥有 23 个领先模型

AI 生态系统

Nvidia 的成功不仅在于技术本身,更在于其构建的庞大而繁荣的生态系统。他们通过与各行各业的领导者合作,将 AI 能力深度集成到世界的每一个角落。

无处不在的平台

Nvidia 的平台之所以能吸引大量初创公司,是因为其无处不在的可用性。无论是在各大云服务商(AWS、Google Cloud、Microsoft Azure、Oracle),还是在本地,甚至是在一台游戏 PC 上,开发者都可以下载和使用统一的 Nvidia 软件栈。同时,也涌现了像 CoreWeave、Lambda 等新兴的 GPU 云服务商,为初创企业提供了更多选择

与行业巨头的深度集成

Nvidia 不仅提供底层算力,还将其 CUDA X 库和 AI 模型集成到全球领先的企业软件(SaaS)中,使它们最终能演变为“代理式 SaaS”。

ServiceNow:承载了全球 85% 的企业工作流

SAP:处理了全球 80% 的商业交易。

Synopsis & Cadence:加速全球的 EDA(电子设计自动化)和 CAE 工具,并帮助它们创建 AI 设计师代理

重磅新合作:网络安全与商业洞察

演讲中老黄宣布了两项新的重要合作:CrowdStrike:Nvidia 与全球领先的网络安全公司 CrowdStrike 合作,旨在打造光速的网络安全防御体系。通过在云端和边缘部署超智能的 AI 代理,实现对安全威胁的瞬时检测与响应

Palantir:Palantir 的 Ontology 平台是全球最重要的企业级决策系统之一,它将数据和人类判断转化为商业洞察。Nvidia 将与其合作,利用加速计算,以光速和前所未有的规模处理结构化和非结构化数据,为政府、国家安全和全球企业提供更深层次的洞察力

物理 AI

老黄演讲的最后一部分聚焦于物理 AI,即能理解并与物理世界互动的 AI,其两大主要应用是机器人和自动驾驶汽车

物理 AI 的三位一体计算平台

实现物理 AI 需要三种不同类型的计算机协同工作,它们都运行在统一的 CUDA 平台上:

1. 训练计算机:Grace Blackwell NVLink 72 这样的 AI 超级计算机,用于训练物理 AI 的基础模型。

2. 模拟计算机:基于 Omniverse 的计算机,它是一个数字孪生平台。机器人可以在这个虚拟世界中安全、高效地学习如何成为一个好机器人,而无需在现实世界中进行昂贵且危险的试错。

3. 操作计算机:Jetson Thor 这样的高性能、低功耗的机器人计算机,被部署在机器人或汽车上,用于在现实世界中执行任务。

人形机器人的未来

Nvidia 正与多家领先的机器人公司合作,共同推动人形机器人的发展

* **Figure**:其先进的人形机器人正在使用 Nvidia 的全套平台进行训练、模拟和操作。 * **Agility Robotics**:专注于仓储自动化机器人。 * **强生(Johnson & Johnson)**:开发的外科手术机器人,将在 Nvidia 技术的支持下,实现前所未有的无创手术精度。 * **迪士尼(Disney)**:合作开发了可爱的机器人 Blue,并在基于革命性技术 Newton 的全新模拟平台上进行学习,使其能够在物理精确的环境中掌握与世界互动的技能。

老黄预测,人形机器人很可能成为未来最大的消费电子市场和工业设备市场之一。

自动驾驶的拐点:从平台到网络

在所有机器人中,最接近商业化拐点的是自动驾驶汽车,尤其是自动驾驶出租车(Robo-taxi),Nvidia 推出了 Drive Hyperion,一个标准化的自动驾驶汽车平台。它集成了一套完整的、具备冗余的传感器套件(环视摄像头、雷达、激光雷达),旨在达到最高的安全级别

像 Lucid、梅赛德斯-奔驰、Stellantis 等多家汽车制造商已经采用了这个平台来制造“Robo-taxi Ready”的车辆

一旦有了标准化的硬件平台,众多优秀的自动驾驶软件公司(如 Wayve、Wabbi、Aurora、Momenta 等)就可以将其 AI 驾驶系统部署到任何符合该标准的车辆上,就像在标准化的 PC 上安装软件一样

最后,Nvidia 宣布与 Uber 合作,计划将这些基于 Drive Hyperion 的自动驾驶汽车连接到一个全球性的出行网络中。未来,用户可以通过 Uber 应用呼叫到这些由 Nvidia 技术驱动的自动驾驶汽车,这将催生一个庞大而成功的新计算平台

延伸阅读:

库克称AirPods Pro 3太火了,苹果始料未及

IT之家 1 月 30 日消息,路透社今天(1 月 30 日)发布博文,报道称在 2026 财年第 1 财季(截至 20...

中信证券:海外AI模型与应用密集催化推动下 算力产业链或迎来新一轮上涨

智通财经APP获悉,中信证券发布研报称,近期,海外推理和训练算力需求旺盛,亚马逊云和谷歌云双双涨价。推理侧、训练侧对于云...

新研究揭示开源AI模型安全风险:若脱离限制运行或将被黑客劫持

IT之家 1 月 30 日消息,路透社 1 月 29 日援引一项最新研究称,开源大语言模型若脱离主流平台的护栏与限制,在...

iPhone录得历史最佳季度表现,但苹果预计存储涨价将影响毛利率

当地时间1月29日,苹果发布了截至2025年12月27日的2026财年第一季度财报。该季度苹果营收1437.6亿美元,同...